▲

- O avanço rápido das deepfakes no Brasil supera a criação de leis específicas, ampliando riscos de desinformação e violência digital.

- Você deve ficar atento ao compartilhar vídeos nas redes sociais, pois conteúdos falsos podem causar danos reais à sua reputação e segurança.

- Deepfakes impactam a sociedade ao influenciar eleições, dificultar provas legais e aumentar a exposição a golpes e violência digital.

- A ausência de regulamentação clara dificulta ações eficazes do Judiciário, plataformas e autoridades na contenção dessas ameaças.

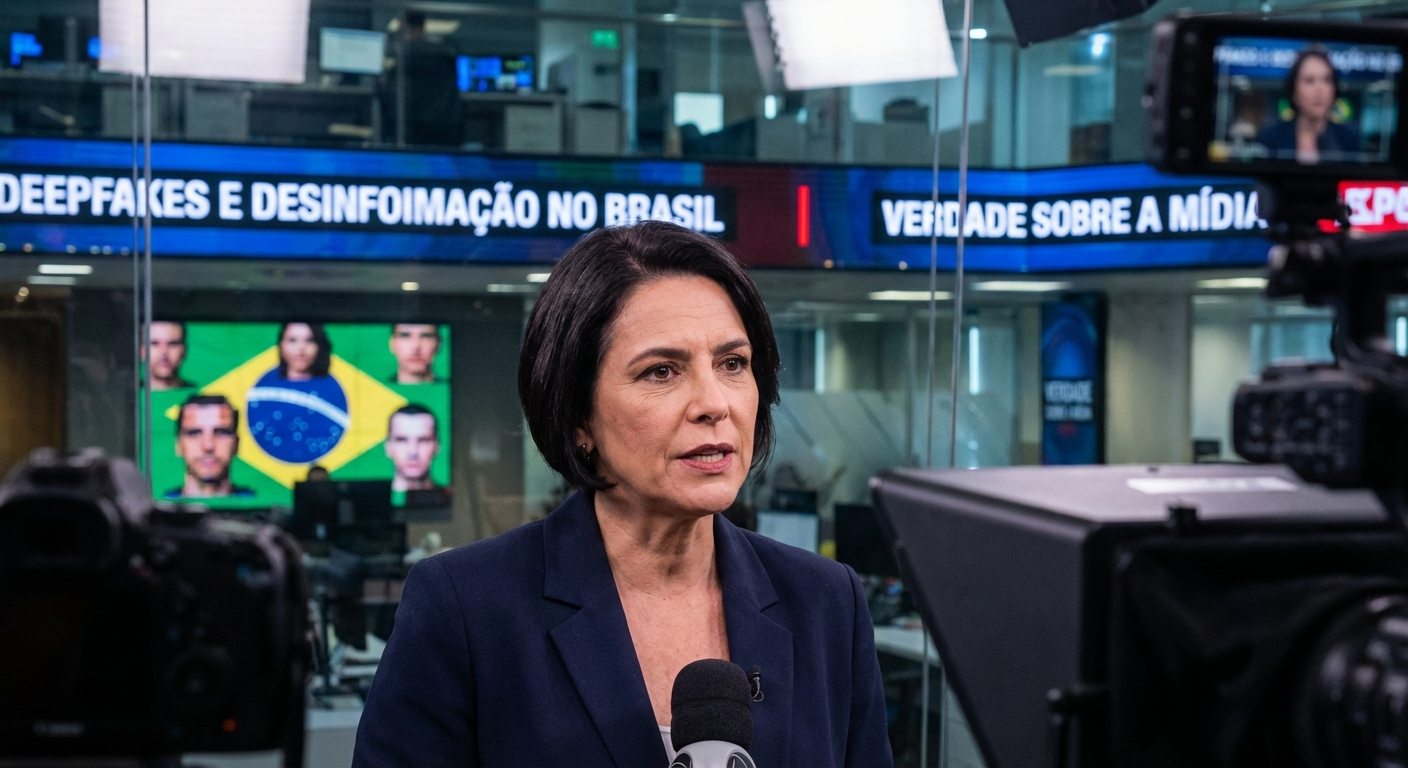

O avanço das deepfakes no Brasil acontece mais rápido do que a criação de leis específicas, abrindo espaço para novas formas de desinformação em eleições, violência digital e golpes financeiros. A ausência de uma regulamentação clara coloca Judiciário, plataformas e cidadãos em uma corrida de improviso.

Deepfakes no Brasil: de brincadeira de internet a arma política silenciosa

Os vídeos gerados por inteligência artificial começaram circulando como memes, dublagens engraçadas e montagens de celebridades. Em pouco tempo, tornaram-se ferramenta para fraudes, ataques pessoais e manipulação em massa.

No cenário brasileiro, essa tecnologia chega num ambiente já marcado por ondas de boatos virais, disparos em massa e falta de transparência sobre o funcionamento dos algoritmos de recomendação.

Especialistas em direito digital e em segurança da informação alertam que, diferentemente de textos ou montagens simples, um vídeo hiper-realista em que alguém parece falar ou fazer algo tem impacto emocional muito maior sobre quem assiste.

Isso vale tanto para disputas políticas quanto para crimes contra a honra, extorsões e montagens de conteúdo íntimo, área em que vítimas relatam dificuldade para provar falsidade e para remover o material das plataformas sociais no Brasil.

Leis existentes, lacunas gigantes: como o ordenamento brasileiro tenta alcançar as deepfakes

Hoje, casos envolvendo montagens digitais acabam enquadrados em leis que não foram desenhadas pensando em inteligência artificial generativa. Advogados recorrem a dispositivos de calúnia, difamação, ameaça, estelionato e crimes virtuais já consolidados.

A Lei Carolina Dieckmann, o Marco Civil da Internet e a Lei Geral de Proteção de Dados aparecem como base frequente, mas nenhuma delas define com precisão o que é uma deepfake e como deve ser tratada em diferentes contextos.

Na prática, isso leva a decisões judiciais desiguais, prazos demorados para remoção de conteúdo e dificuldade para responsabilizar tanto autores quanto plataformas, cenário semelhante ao observado em outros tipos de fake news com IA.

Mesmo com o avanço de debates regulatórios em torno da inteligência artificial, ainda há dúvidas sobre até onde o Estado pode obrigar empresas a filtrarem conteúdo sintético sem ferir liberdade de expressão ou censurar criações legítimas, como paródias e filmes.

Eleições, campanhas sujas e medo de um ciclo permanente de desinformação

Autoridades eleitorais brasileiras já encaram as deepfakes como risco concreto para próximos pleitos. A preocupação não é apenas com vídeos longos e bem produzidos, mas também com clipes curtos que circulam em massa em aplicativos de mensagens.

Em disputas acirradas, alguns segundos de um candidato aparentemente assumindo um crime, insultando grupos sociais ou prometendo medidas impopulares podem ser suficientes para alterar o humor do eleitorado, mesmo que o vídeo seja desmentido depois.

Essa dinâmica se soma a estruturas de desinformação já conhecidas, que utilizam automação, robôs, anúncios segmentados e estratégias coordenadas de engajamento em redes sociais para amplificar narrativas falsas em poucos minutos.

Órgãos públicos avaliam novas formas de fiscalização, mas ainda enfrentam limitações técnicas, orçamentárias e jurídicas semelhantes às registradas em discussões sobre fake news de IA nas eleições brasileiras, com pressão crescente sobre tribunais e reguladores.

Montagens sexuais e violência digital: o ponto mais doloroso da ausência de regras

Um dos usos mais agressivos de deepfakes no país está nas montagens sexuais não consentidas, que atingem principalmente mulheres, adolescentes e pessoas em situação de vulnerabilidade. Muitas vítimas só descobrem os vídeos quando colegas ou familiares avisam.

Em vários casos, o material é publicado em sites anônimos ou grupos fechados, dificultando a identificação de quem criou e de quem compartilhou. Mesmo quando o conteúdo é removido, cópias reaparecem em outros serviços, mantendo a exposição por tempo indeterminado.

Organizações de defesa de direitos digitais apontam que a legislação brasileira sobre filmagens íntimas sem consentimento e sobre câmeras escondidas foi desenhada para situações analógicas, sem considerar imagens sintéticas hiper-realistas.

Nesse contexto, plataformas sociais no Brasil são pressionadas a reagir de forma mais rápida a denúncias, mas ainda operam com políticas próprias, sem padrão legal definido, o que gera sensação de insegurança entre vítimas e especialistas.

Judiciário sobrecarregado e investigações que ainda engatinham

Peritos em informática forense relatam aumento de pedidos para analisar se vídeos são autênticos ou gerados por IA, inclusive em disputas trabalhistas, conflitos familiares e processos criminais. A demanda, porém, cresce mais rápido que a oferta de profissionais qualificados.

Embora existam ferramentas técnicas para identificar padrões de manipulação, compressão de imagem e inconsistências em sombras, reflexos e áudio, a sofisticação dos modelos mais recentes torna a perícia cada vez mais complexa e cara.

Isso significa que, em muitos casos, vítimas de baixa renda acabam sem meios para comprovar a falsidade do material, o que amplia a assimetria entre quem tem recursos para defesa e quem depende exclusivamente da estrutura pública.

No campo policial, delegacias especializadas em crimes cibernéticos relatam dificuldade em rastrear autores quando as montagens passam por múltiplos servidores, VPNs e serviços estrangeiros, cenário que remete a outros eventos graves de vazamento e exposição de dados pessoais no país.

Plataformas de IA e responsabilidade: quem deve responder pela avalanche de conteúdo sintético?

Outro debate sensível passa pelo papel das empresas que oferecem modelos generativos, editores de vídeo com filtros automáticos e aplicativos que prometem “transformar qualquer foto em filme”. Em muitos casos, basta uma imagem pública para produzir uma sequência inteira.

As políticas de uso de algumas plataformas permitem esse tipo de criação desde que marcadas como conteúdo manipulado, mas a marcação pode ser removida, cortada ou simplesmente ignorada quando o vídeo circula em canais paralelos.

Pesquisadores em IA defendem mecanismos técnicos de marca d’água e rastreabilidade, capazes de sinalizar que determinado arquivo foi gerado por máquina. Porém, esses recursos enfrentam resistência de desenvolvedores preocupados com performance, privacidade e liberdade criativa.

No cenário internacional, surgem discussões sobre padrões mínimos de segurança em ferramentas de geração de imagens e vídeos, enquanto o Brasil encara as mesmas tensões em outros temas relacionados ao poder de grandes modelos de IA e à necessidade de políticas públicas mais consistentes.

Projetos de lei, debates em Brasília e a pressão por uma regulamentação específica

No Congresso Nacional, multiplicam-se propostas que tentam enquadrar deepfakes dentro de uma política ampla de inteligência artificial. Algumas defendem obrigações de rotulagem, outras sugerem novos tipos penais ou aumento de pena quando houver uso de IA para fraudar.

Parlamentares também discutem se a responsabilização deve se concentrar no autor do conteúdo, nos financiadores de campanhas de desinformação ou nas plataformas que lucram com engajamento gerado por vídeos falsos.

Há receio de que normas muito rígidas desestimulem pesquisa e desenvolvimento tecnológico no país, inclusive em setores que usam IA para educação, saúde e segurança, como já ocorre em discussões sobre uso da tecnologia em escolas brasileiras.

Por outro lado, movimentos da sociedade civil e especialistas em direitos humanos alertam que a demora em definir parâmetros mínimos deixa abertas portas para abusos em larga escala, sobretudo em contextos eleitorais e em situações de exposição íntima.

Desinformação com IA e democracia: o risco de normalizar o que é falso

À medida que deepfakes se tornam mais comuns, existe o risco de um efeito duplo perigoso. De um lado, pessoas acreditam em montagens realistas sem checar fontes. De outro, figuras públicas começam a negar vídeos verdadeiros, alegando que tudo seria “apenas IA”.

Esse fenômeno, conhecido como “efeito do mentiroso”, enfraquece a confiança coletiva em registros audiovisuais, que sempre foram usados como prova em investigações jornalísticas, processos judiciais e fiscalizações oficiais.

Se a população passa a duvidar de qualquer evidência visual, abre-se espaço para que narrativas falsas ganhem força, mesmo diante de dados técnicos e laudos periciais. Isso atinge diretamente a capacidade de funcionamento de instituições democráticas.

Ao mesmo tempo, cresce a dependência de plataformas e sistemas automatizados na curadoria de informação, um cenário que conversa com outras discussões sobre como algoritmos de recomendação priorizam conteúdos duvidosos e podem favorecer ambientes de polarização.

Educação midiática e ferramentas de checagem: a defesa possível enquanto a lei não chega

Diante da lentidão legislativa, muitas ações de proteção passam pela combinação de educação digital, checagem de fatos e desenvolvimento de soluções tecnológicas para tentar identificar manipulações em larga escala.

Iniciativas de letramento midiático em escolas, universidades e organizações da sociedade civil buscam ensinar o público a desconfiar de vídeos sem origem clara, a verificar fontes e a entender como funcionam os modelos generativos.

Veículos de comunicação, coletivos independentes e laboratórios acadêmicos testam softwares capazes de detectar ruídos típicos de deepfakes, como piscadas artificiais, falhas de sincronização labial e padrões de iluminação incoerentes.

Essas estratégias, porém, só ganham força quando combinadas com políticas públicas consistentes para combater fake news de IA, com papéis definidos para governo, empresas, instituições de ensino e usuários finais.

Caminhos possíveis: do rótulo obrigatório à cooperação internacional

Entre as propostas em discussão, algumas ideias aparecem com mais frequência: rotulagem obrigatória de conteúdo sintético em plataformas, protocolos de resposta rápida a denúncias e criação de selos oficiais para vídeos e transmissões verificadas.

Outros caminhos incluem parcerias entre governos, universidades e empresas para compartilhar bases de dados usadas no treinamento de detectores de deepfakes, permitindo que as ferramentas acompanhem a velocidade da evolução dos modelos generativos.

Também há espaço para acordos internacionais, dado que vídeos podem ser produzidos em qualquer país e distribuídos globalmente em segundos, o que torna insuficiente qualquer esforço isolado de um único Estado nacional.

Enquanto essas medidas não se consolidam, o debate público em torno da regulação da inteligência artificial no Brasil tende a ganhar peso, especialmente em anos de eleições, crises políticas ou grandes casos de exposição indevida de imagens pessoais.

O que pode mudar na rotina de quem vive conectado no Brasil

Para o usuário comum, o aumento da circulação de deepfakes significa necessidade de mais atenção ao compartilhar conteúdos, especialmente em grupos de família, trabalho e comunidades locais. O simples encaminhamento de um vídeo falso pode gerar danos reais.

Empresas precisarão reforçar políticas internas de comunicação, garantir canais oficiais verificados e monitorar menções a marcas e executivos em plataformas sociais, em um ambiente em que boatos e montagens podem afetar reputações em minutos.

Órgãos públicos terão de investir em infraestrutura técnica, capacitação de peritos e protocolos de cooperação entre polícia, Ministério Público, tribunais e agências reguladoras, para responder de forma coordenada a casos que envolvam IA generativa.

A sociedade brasileira, acostumada a conviver com ondas de boatos e disputas acaloradas nas redes, passa a encarar uma etapa nova, em que som, imagem e vídeo já não são sinônimo automático de verdade, e em que o atraso na definição de regras claras cobra um preço alto para a confiança coletiva.