Em um novo documento de políticas intitulado “Frontier AI Framework”, a Meta afirma que não lançará modelos de IA com alto nível de capacidade se eles apresentarem muitos Riscos de IA da Meta. A empresa reconhece os riscos potenciais do desenvolvimento de Inteligência Artificial Geral (AGI), sistemas de IA capazes de executar tarefas humanas.

Meta e os Riscos de IA da Meta: Um Novo Framework de Segurança

A corrida pelo desenvolvimento de modelos avançados de IA, comumente chamados de AGI, traz preocupações sobre os riscos associados a sistemas capazes de realizar qualquer tarefa humana. A Meta, ciente dessa ameaça, elaborou o “Frontier AI Framework”, um documento que detalha seus esforços para criar sistemas de IA eficazes e, ao mesmo tempo, monitorar seus possíveis efeitos negativos.

O documento destaca os benefícios desses sistemas avançados, mas também alerta para a possibilidade de “resultados catastróficos”. A Meta define dois tipos de sistemas de IA considerados arriscados: “alto risco” e “risco crítico”, exemplificados por modelos que auxiliam em cibersegurança e ataques químicos e biológicos. Situações que envolvam esses sistemas podem levar a consequências catastróficas.

A Meta afirma que interromperá imediatamente o desenvolvimento e o lançamento de qualquer sistema identificado como de “risco crítico”. Entretanto, a empresa admite a possibilidade, ainda que remota, de um sistema de IA ser lançado mesmo com riscos. Nesse caso, medidas serão tomadas para evitar cenários catastróficos, embora a Meta reconheça que essas medidas podem ser insuficientes.

A Meta realiza testes internos e com especialistas externos para modelar ameaças e entender como modelos de IA podem ser usados para causar danos. Esses testes simulam cenários de ameaça para identificar se o modelo de IA em questão facilitaria a concretização desses cenários e quais capacidades o modelo precisaria ter para isso. Caso essas capacidades estejam presentes e o modelo seja eficiente o suficiente, avaliações adicionais serão conduzidas. A segurança em redes 5G, por exemplo, enfrenta desafios emergentes com o avanço da inteligência artificial, e a Meta busca se antecipar a esses desafios.

Leia também:

Mesmo com as medidas internas da Meta para controlar o lançamento de modelos de IA potencialmente perigosos, é provável que haja intervenção legal. A questão agora é até onde esse desenvolvimento pode chegar. A OpenAI Deep Research, por exemplo, apresenta uma IA avançada para enfrentar tarefas complexas de forma autônoma, levantando ainda mais questões sobre o futuro da IA.

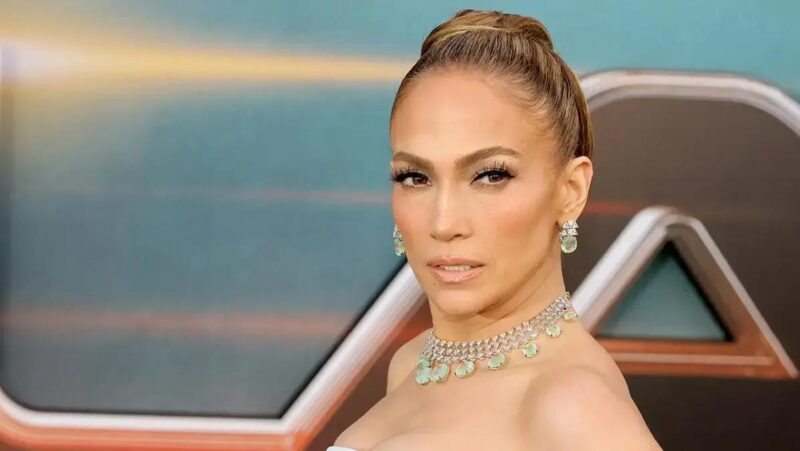

Além dos Riscos: O Futuro da IA segundo Mark Zuckerberg

Em meio a discussões sobre os Riscos de IA da Meta, Mark Zuckerberg prevê que a IA poderá substituir engenheiros de nível médio em 2025 e remodelar completamente a codificação. Essa previsão levanta questões sobre o futuro do mercado de trabalho em tecnologia. Além disso, Zuckerberg alertou para um ano desafiador, com planos de cortar 5% da força de trabalho da Meta para lidar com o baixo desempenho.

A Meta também lançou um novo recurso no Instagram que permite aos usuários redefinir o conteúdo recomendado no Explore, Reels e Feed. Esta mudança busca dar mais controle aos usuários sobre o conteúdo que visualizam na plataforma. Enquanto isso, a empresa trabalha no desenvolvimento dos óculos Orion, visando torná-los os “AirPods da realidade aumentada”, menos intrusivos e mantendo os usuários conectados à realidade. Com o avanço da tecnologia de IA, a Apple Vision Pro completa um ano e questiona o que vem a seguir para o dispositivo, abrindo espaço para novas possibilidades.

Este conteúdo foi auxiliado por Inteligência Artificial, mas escrito e revisado por um humano.

Via Wccftech