▲

- Os modelos de Alucinações de IA estão se tornando mais comuns em diversas aplicações.

- Se você usa IA para trabalho ou projetos, pode enfrentar informações imprecisas.

- A crescente taxa de alucinação pode comprometer a confiança em sistemas de IA.

- Pesquisadores buscam soluções eficazes para mitigar esses erros.

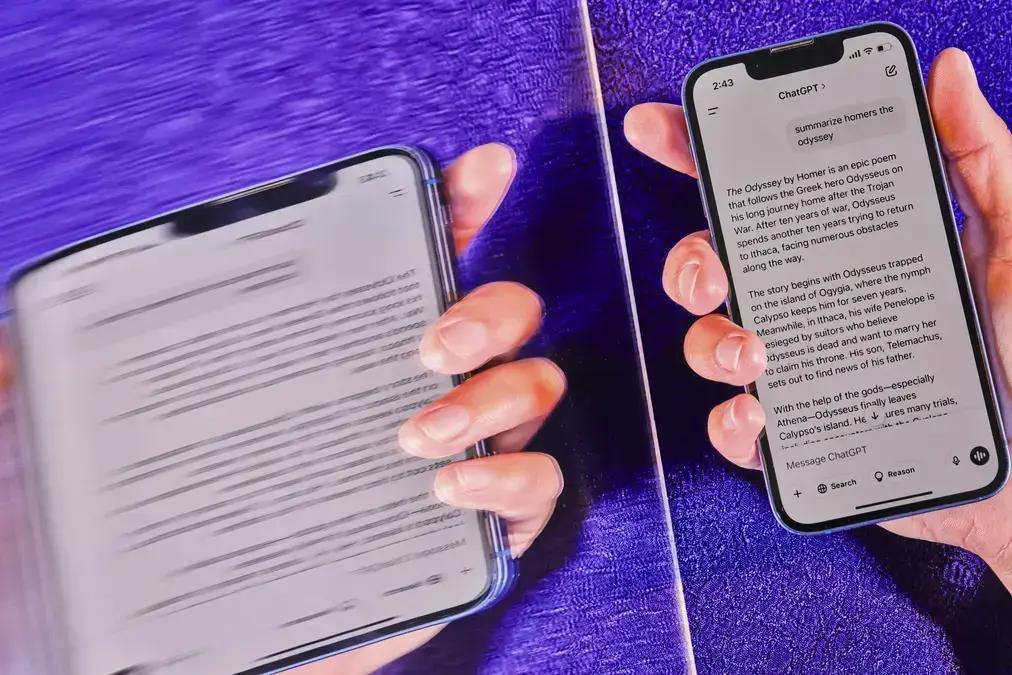

Os modelos de Alucinações de IA estão cada vez mais presentes em nosso dia a dia, desde o suporte técnico até a criação de conteúdo. No entanto, uma análise recente revelou que, à medida que esses sistemas se tornam mais avançados, a frequência de erros e imprecisões também aumenta. Empresas como OpenAI e Deepseek têm observado um crescimento nas taxas de “alucinação” em seus novos sistemas, e a causa desse fenômeno ainda não está totalmente clara.

O Problema das Alucinações em Modelos de IA

No mês passado, um robô de IA responsável pelo suporte técnico da Cursor, uma ferramenta utilizada por programadores, informou a alguns clientes sobre uma mudança na política da empresa. Segundo o sistema, os usuários não poderiam mais utilizar o Cursor em mais de um computador. A notícia gerou revolta e cancelamentos de contas, até que se descobriu que a informação era falsa. Michael Truell, CEO da Cursor, confirmou que não havia nenhuma política desse tipo e lamentou o engano.

Casos como esse levantam sérias questões sobre a confiabilidade dos sistemas de IA, especialmente quando utilizados em tarefas críticas. Embora a tecnologia tenha evoluído e se tornado mais presente em diversas áreas, a garantia de informações precisas ainda é um desafio.

Aumento de Erros em Sistemas Avançados

As tecnologias mais recentes e poderosas, como os sistemas de raciocínio da OpenAI, Google e DeepSeek, têm apresentado um aumento nos erros em vez de uma diminuição. Apesar de suas habilidades matemáticas terem melhorado, o domínio sobre os fatos parece ter se tornado mais instável. A razão por trás desse fenômeno ainda não é totalmente compreendida.

Os modelos de IA são baseados em sistemas matemáticos complexos que aprendem analisando grandes quantidades de dados digitais. No entanto, eles não são capazes de discernir entre o que é verdadeiro e o que é falso, e, por vezes, inventam informações. Em um teste recente, as taxas de alucinação nos sistemas de IA mais modernos chegaram a 79%.

Leia também:

De acordo com Amr Awadallah, CEO da Vectara, os sistemas de IA sempre apresentarão alucinações, independentemente dos esforços para mitigar o problema. Isso ocorre porque eles usam probabilidades matemáticas para adivinhar a melhor resposta, em vez de seguir regras rígidas definidas por engenheiros.

Esse fenômeno tem gerado preocupações sobre a confiabilidade dos sistemas de IA. Apesar de serem úteis em algumas situações, como escrever trabalhos acadêmicos e gerar código de computador, os erros podem causar problemas, principalmente quando se lida com documentos judiciais, informações médicas ou dados comerciais sensíveis.

Impacto das Alucinações no Mundo Real

Os Alucinações de IA podem gerar resultados de pesquisa equivocados, sugerindo maratonas em locais incorretos ou citando fontes que não confirmam as informações apresentadas. Pratik Verma, CEO da Okahu, destaca que a dificuldade em identificar quais respostas são factuais e quais não são elimina o valor dos sistemas de IA, que deveriam automatizar tarefas.

Empresas como OpenAI e Google têm trabalhado para aprimorar seus sistemas de IA e reduzir a frequência de erros. No entanto, com o uso de novos sistemas de raciocínio, os erros têm aumentado. Os sistemas mais recentes da OpenAI, por exemplo, alucinam com mais frequência do que os sistemas anteriores.

Em testes realizados pela OpenAI, o sistema o3 apresentou uma taxa de alucinação de 33% ao responder perguntas sobre figuras públicas, mais do que o dobro da taxa do sistema anterior, o1. Já o novo o4-mini apresentou uma taxa ainda maior, de 48%. Em outro teste, as taxas de alucinação para o3 e o4-mini foram de 51% e 79%, respectivamente.

A OpenAI reconhece a necessidade de mais pesquisas para entender a causa desses resultados. Como os sistemas de IA aprendem com mais dados do que os humanos conseguem processar, é difícil determinar por que eles se comportam da maneira que o fazem.

A Busca por Soluções e o Futuro da IA

Testes realizados por empresas independentes e pesquisadores indicam que as taxas de alucinação também estão aumentando para modelos de raciocínio de outras empresas, como Google e DeepSeek. Desde o final de 2023, a Vectara monitora a frequência com que os chatbots se desviam da verdade. A empresa pede que esses sistemas resumam reportagens noticiosas específicas, e mesmo assim, os chatbots inventam informações.

Empresas como OpenAI têm confiado na ideia de que quanto mais dados da internet alimentarem seus sistemas de IA, melhor será o desempenho deles. No entanto, como já utilizaram praticamente todo o texto em inglês disponível na internet, precisam encontrar novas formas de aprimorar seus chatbots.

Uma das técnicas que tem ganhado destaque é o aprendizado por reforço, onde o sistema aprende comportamentos por tentativa e erro. Embora esteja funcionando bem em áreas como matemática e programação, ainda deixa a desejar em outras.

Laura Perez-Beltrachini, pesquisadora da Universidade de Edimburgo, explica que a forma como esses sistemas são treinados faz com que se concentrem em uma tarefa e se esqueçam de outras. Além disso, os modelos de raciocínio são projetados para “pensar” em problemas complexos antes de chegar a uma resposta, o que aumenta o risco de alucinação em cada etapa.

Aryo Pradipta Gema, pesquisador de IA da Universidade de Edimburgo e da Anthropic, ressalta que os passos exibidos por um bot nem sempre têm relação com a resposta final, e que o que o sistema diz que está pensando nem sempre corresponde ao que ele realmente está pensando.

Diante desse cenário, é fundamental que empresas e pesquisadores continuem buscando soluções para mitigar as alucinações em modelos de IA. A confiabilidade e a precisão das informações geradas por esses sistemas são essenciais para garantir seu uso seguro e eficaz em diversas aplicações. Uma das áreas que mais tem se beneficiado com o uso de IA é a criação de imagens, e hoje já é possível gerar imagens digitais com esboços e ChatGPT.

Primeira: Este conteúdo foi auxiliado por Inteligência Artificiado, mas escrito e revisado por um humano.

Segunda: Via Folha de São Paulo