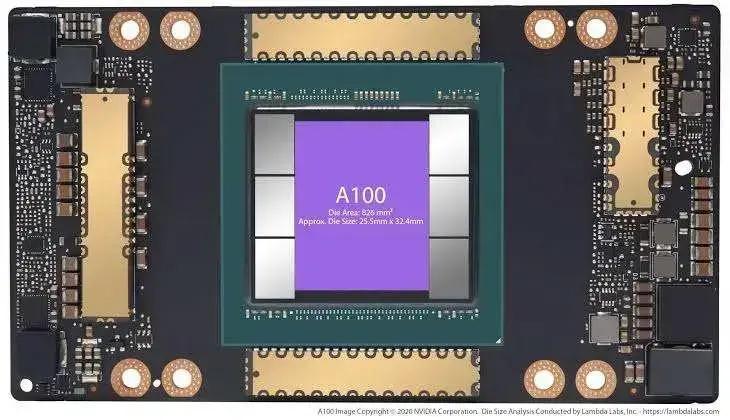

A Patente da NVIDIA visa otimizar o uso de GPUs em computação de inteligência artificial, buscando solucionar gargalos de velocidade. A empresa propõe um sistema onde diferentes partes da GPU trabalham de forma independente para armazenar e acessar dados, diminuindo os atrasos causados pelo acesso a recursos computacionais distantes. Essa inovação promete acelerar os cálculos e impulsionar aplicações de IA mais poderosas.

A NVIDIA, líder no mercado de GPUs, continua investindo em inovação para manter sua posição de destaque no setor de inteligência artificial. Recentemente, a empresa registrou uma nova patente que busca solucionar um dos maiores desafios da computação de IA: como construir GPUs cada vez mais potentes sem comprometer a velocidade.

Para entender melhor essa nova patente, vamos explorar os detalhes e o impacto potencial dessa tecnologia.

Como a Patente da NVIDIA pretende solucionar os desafios da computação de IA?

A nova patente da NVIDIA, de número US20250078199A1, propõe uma solução inovadora para acelerar os cálculos realizados pelas GPUs. A ideia central é permitir que diferentes seções da GPU operem de forma independente, armazenando e acessando dados localmente. Isso reduziria significativamente os atrasos causados pelo acesso a recursos computacionais que estão distantes.

Imagine que a GPU é como uma cidade. No modelo tradicional, todos os bairros precisam acessar os mesmos recursos, causando congestionamento e atrasos. Com a solução da NVIDIA, cada bairro (seção da GPU) teria seus próprios recursos, diminuindo a necessidade de deslocamento e agilizando o trabalho.

Leia também:

Essa abordagem tem o potencial de acelerar drasticamente os cálculos realizados pelas GPUs, o que abriria portas para o desenvolvimento de aplicações de inteligência artificial ainda mais poderosas e complexas.

Para alcançar essa localização, a patente da NVIDIA descreve três componentes principais:

1. Unidade de Mapeamento de Endereços AMAP: Essa unidade oferece uma visão alternativa da memória localizada, permitindo o remapeamento da memória física para a DRAM local associada a uma dada uGPU (micro GPU).

2. Sistema de Máscara de Afinidade do Cluster de Processamento Gráfico (GPC): Esse sistema permite alocar um programa de computação para GPCs específicos, confinando sua execução a um nó uGPU delimitado.

3. Um Gerenciador de Recursos de GPU.

Funcionamento da Localização da GPU

Como funciona a localização da GPU proposta pela NVIDIA? Uma aplicação de IA informa ao driver CUDA sua intenção de se ligar a um nó uGPU através da máscara de afinidade. O driver CUDA, então, coordena com o Gerenciador de Recursos para aplicar o mapeamento localizado.

Simultaneamente, a memória alinhada com um dado nó uGPU é subalocada para aquele nó. Em seguida, o driver CUDA aloca o trabalho computacional para os GPCs controlados pelo nó uGPU designado. Além disso, os threads CTA acessam a memória usando o mapeamento de endereço localizado, enquanto as solicitações de memória são confinadas à DRAM local de um dado uGPU.

A arquitetura proposta pela NVIDIA, conforme explicado em seu pedido de patente, reduziria significativamente os problemas de latência relacionados ao acesso à memória, aumentaria a eficiência do cache ao eliminar o armazenamento de dados redundantes, resolveria problemas de latência inerentes à comunicação cross-die e daria às aplicações um controle mais granular sobre a alocação e utilização de recursos da GPU.

Essa patente pode funcionar como mais uma forma de superar as limitações associadas à Lei de Moore, confiando na localização em vez da miniaturização para acelerar os cálculos.

Em alguns aspectos, essa abordagem é semelhante à utilizada pela [DeepSeek](https://x.com/danielhanchen/status/1895698283588468785), onde a startup chinesa de IA conseguiu desbloquear capacidades adicionais das GPUs de geração mais antiga da NVIDIA para impulsionar uma melhoria significativa nos recursos computacionais disponíveis.

Este conteúdo foi auxiliado por Inteligência Artificial, mas escrito e revisado por um humano.