▲

- Modelos de IA estão apresentando cada vez mais alucinações, criando informações falsas.

- Isso pode impactar sua rotina ao usar IAs para tarefas críticas, como pesquisa médica.

- O aumento das alucinações pode afetar a confiança nos sistemas inteligentes na sociedade.

- Especialistas alertam sobre a necessidade de aprimorar a confiabilidade das IAs.

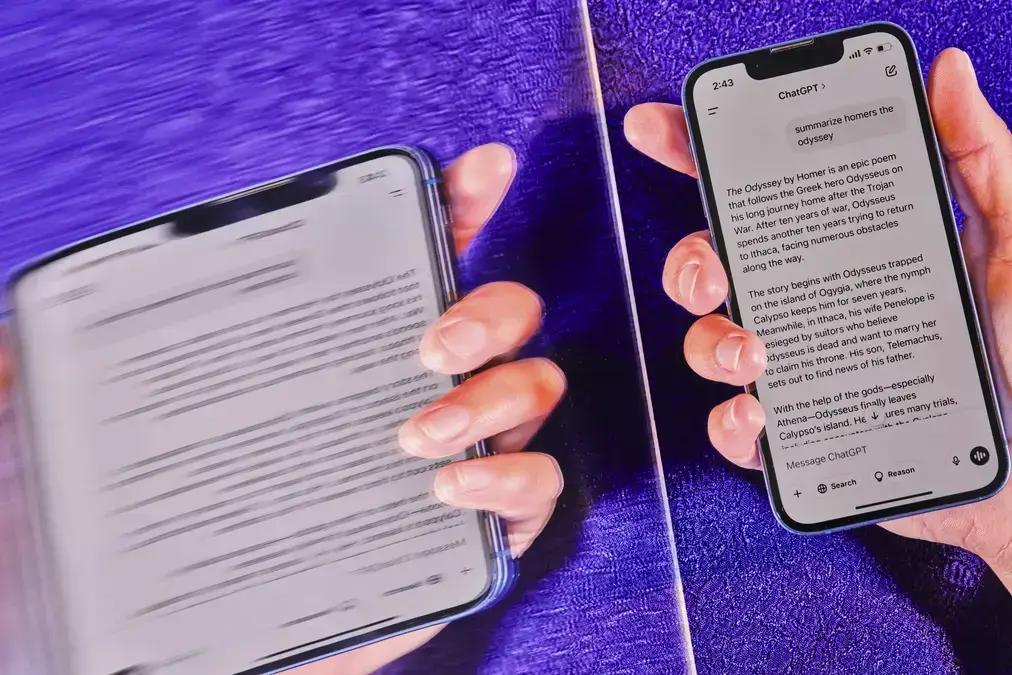

Você já ouviu falar que a inteligência artificial está “alucinando”? Calma, não é nada de ficção científica! Modelos de IA, como os da OpenAI e Google, estão inventando informações com mais frequência, um fenômeno chamado de “alucinação”. E o pior: quanto mais avançados, mais propensos a esses erros eles parecem ser. Vamos entender por que isso acontece e como isso pode afetar o nosso dia a dia.

Afinal, o que são essas “alucinações” da IA?

Imagine um robô que, em vez de te dar a resposta certa, inventa algo completamente do nada. É isso que acontece quando uma IA “alucina”. Esses sistemas, que aprendem analisando uma montanha de dados, não conseguem distinguir o que é verdade do que é falso. Em vez de seguir regras, eles adivinham a resposta mais provável, e às vezes erram feio. Em alguns testes, os erros chegaram a 79%! E não pense que isso vai sumir tão cedo. Segundo especialistas, as alucinações de inteligência artificial vieram para ficar.

Esses deslizes podem parecer inofensivos, mas podem causar problemas. Imagine usar um bot de IA para pesquisar documentos legais, informações médicas ou dados financeiros. Se ele inventar informações, as consequências podem ser sérias. Por isso, muita gente tem se preocupado em como garantir que esses sistemas sejam mais confiáveis.

Uma empresa chamada Okahu, por exemplo, ajuda outras empresas a lidarem com as alucinações da IA. Pratik Verma, CEO da Okahu, explica que o problema é que as pessoas gastam um tempão tentando descobrir o que é verdade e o que não é. Se os erros não forem corrigidos, a IA perde a utilidade, já que ela deveria estar automatizando tarefas.

O que está causando o aumento das alucinações?

Por muito tempo, empresas como OpenAI e Google estavam conseguindo diminuir os erros de seus sistemas de IA. Mas, com os novos sistemas de raciocínio, a situação parece ter se complicado. Os sistemas mais recentes da OpenAI, por exemplo, estão alucinando mais do que os antigos. Em um teste, o sistema mais potente da empresa, o o3, alucinou 33% das vezes ao responder perguntas sobre figuras públicas. O sistema anterior, o o1, alucinou 44% das vezes. Ao executar outro teste com perguntas mais gerais, as taxas de alucinação do o3 e do o4-mini foram de 51% e 79%, respectivamente. E ninguém sabe explicar exatamente o porquê!

Leia também:

A OpenAI admitiu que precisa pesquisar mais para entender esses resultados. Como os sistemas de IA aprendem com dados que as pessoas não conseguem nem imaginar, fica difícil descobrir por que eles se comportam de um jeito ou de outro. Empresas independentes e pesquisadores também notaram que as alucinações estão aumentando em modelos de outras empresas, como Google e DeepSeek.

A Vectara, empresa de Amr Awadallah, está de olho na frequência com que os chatbots inventam coisas. Eles pedem para os sistemas resumirem notícias específicas. Mesmo assim, os chatbots insistem em inventar informações. No começo, os chatbots erravam pelo menos 3% das vezes, chegando a 27% em alguns casos. Depois, empresas como OpenAI e Google conseguiram reduzir esses números para 1% ou 2%. Mas, com os novos sistemas de raciocínio, as taxas de alucinação voltaram a subir.

Durante anos, as empresas de IA acreditaram que, quanto mais dados da internet seus sistemas recebessem, melhor eles se tornariam. Mas agora que já usaram quase todo o texto em inglês disponível na internet, precisam encontrar outras formas de melhorar seus chatbots. Uma delas é o aprendizado por reforço, em que o sistema aprende por tentativa e erro. Essa técnica tem funcionado bem em áreas como matemática e programação, mas não tão bem em outras.

Uma pesquisadora da Universidade de Edimburgo, Laura Perez-Beltrachini, explica que os sistemas começam a focar em uma tarefa e esquecem as outras. Outro problema é que os modelos de raciocínio são projetados para “pensar” em problemas complexos antes de responder. Ao tentar resolver o problema passo a passo, eles correm o risco de alucinar em cada etapa. E, como os erros se acumulam, quanto mais tempo eles pensam, pior fica!

E tem mais: os bots mais novos mostram cada passo para os usuários, o que significa que todo mundo pode ver os erros. Alguns pesquisadores descobriram que, em muitos casos, os passos que o bot mostra não têm nada a ver com a resposta final. Ou seja, o que o sistema diz que está pensando não é necessariamente o que ele está pensando de verdade.

Para você que gosta de ficar por dentro das novidades tecnológicas, vale a pena conferir a newsletter The BRIEF com novidades do mundo tech, relançada pelo TecMundo.

Este conteúdo foi auxiliado por Inteligência Artificial, mas escrito e revisado por um humano.

Via Folha de S.Paulo