▲

- Chatbots de IA, como o Gemini, podem gerar informações imprecisas, afetando a confiança do usuário.

- Adicionar uma frase ao prompt pode fazer com que o chatbot forneça também as fontes das informações.

- Verificar as fontes é essencial para garantir a fidelidade dos dados apresentados.

- Implementar fontes verificáveis aumenta a transparência e a credibilidade dos chatbots.

- O método simples de solicitar fontes pode transformar a utilização de IA em pesquisas mais seguras.

É de conhecimento geral que chatbots de Inteligência Artificial, como o ChatGPT e o Gemini, às vezes podem apresentar informações que não são precisas, o que chamamos de alucinações. Eles podem inventar dados ou distorcer respostas, comprometendo a confiança do usuário. Mesmo que esses casos estejam se tornando menos frequentes, ainda acontecem e podem prejudicar a credibilidade de um serviço. Afinal, qual a utilidade de um assistente se não sabemos quando confiar nele?

O Desafio da Confiabilidade nos Chatbots de IA

A falta de precisão em respostas de inteligência artificial é um ponto de atenção para os usuários. Quando um chatbot “alucina”, ele gera informações que parecem verdadeiras, mas que não correspondem à realidade. Isso pode incluir desde datas erradas até eventos que nunca aconteceram, dificultando a distinção entre fatos e invenções.

Essa característica dos modelos de IA pode abalar a confiança de quem busca informações. Se você não consegue ter certeza de que a resposta obtida é fidedigna, a ferramenta perde parte de seu valor. É por essa razão que muitos usuários preferem plataformas que fornecem as fontes de suas informações, como o Perplexity.

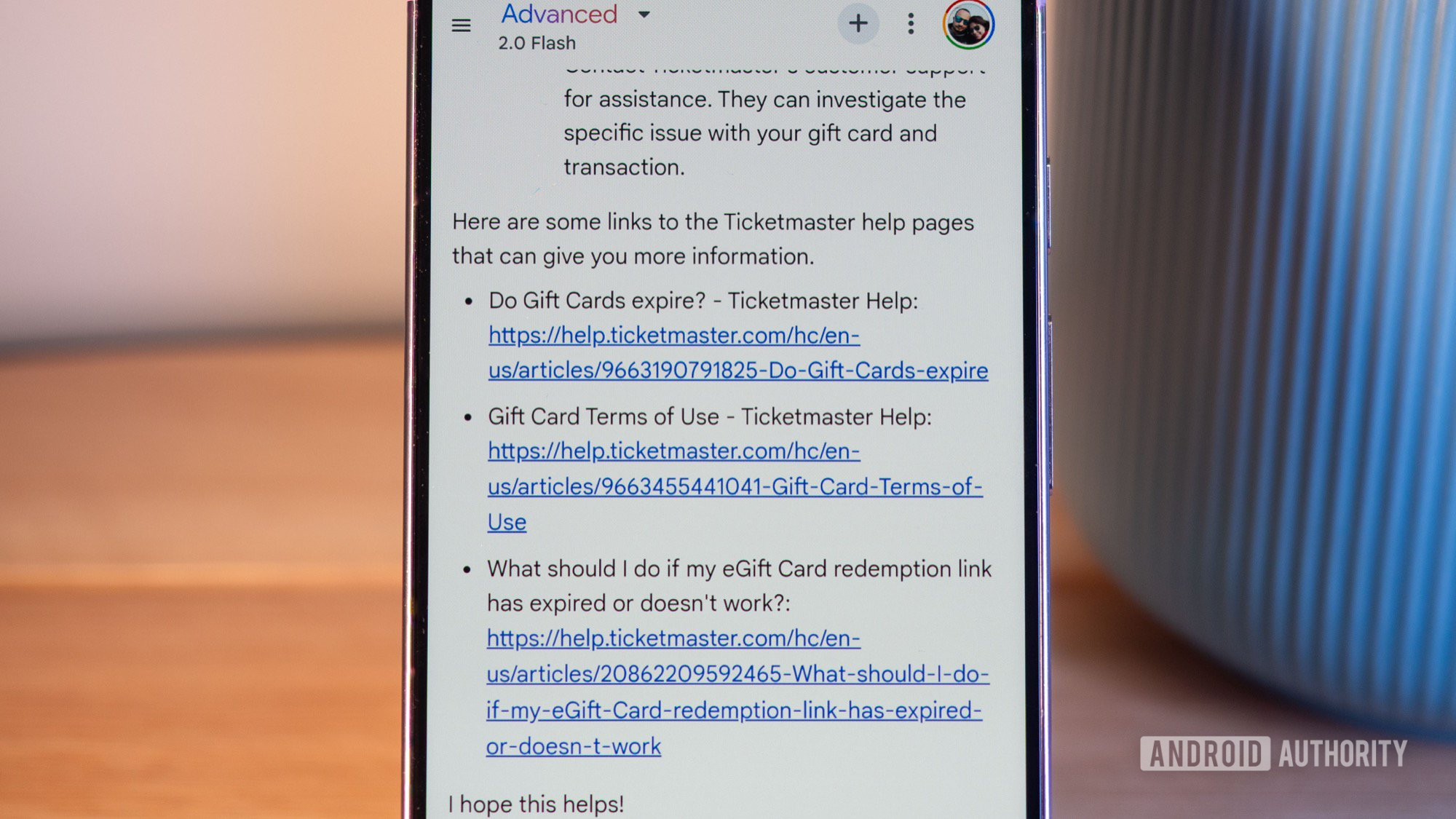

Poder verificar a origem de uma informação é crucial para quem depende desses assistentes em sua rotina. Ao ter acesso aos links de referência, o usuário pode clicar e aprofundar a leitura em sites confiáveis. Isso permite uma validação rápida do conteúdo, garantindo que a informação seja sólida e bem fundamentada.

A transparência sobre as fontes é um diferencial importante no cenário atual dos chatbots. É uma maneira de aumentar a credibilidade da ferramenta, permitindo que o usuário tenha controle sobre a veracidade do que é apresentado. Essa funcionalidade ajuda a mitigar os problemas de informações falsas geradas pela inteligência artificial.

Leia também:

- Anatel alerta governo federal sobre riscos da concentração de data centers em grandes cidades brasileiras

- Anatel alerta governo federal sobre riscos da concentração de data centers em grandes cidades brasileiras

- Anatel determina que bloqueio de chamadas publicitárias pelo ‘Não Me Perturbe’ será obrigatório no Brasil

Como Fazer o Gemini como Perplexity com Fontes Verificáveis

A boa notícia é que existe uma maneira de induzir o Gemini a se comportar de forma similar ao Perplexity, oferecendo as fontes de suas respostas. A solução é surprisingly simples, exigindo apenas uma frase na sua solicitação inicial. Isso transforma a interação com o chatbot, aumentando a sua confiabilidade.

Ao adicionar um comando específico ao seu prompt, o Gemini é instruído a não apenas fornecer a resposta, mas também a listar as referências de onde essa informação foi extraída. Essa prática é fundamental para quem busca dados precisos, permitindo uma investigação mais aprofundada dos tópicos abordados.

Esse pequeno ajuste na sua pergunta inicial pode ser um divisor de águas na forma como você utiliza chatbots de IA para pesquisa. Ele reforça a importância de questionar e validar as informações, especialmente quando se trata de assuntos sensíveis ou que exigem alta precisão. Afinal, a capacidade de melhorar a confiabilidade de chatbots com fontes verificáveis é um passo importante.

A Casa Branca, por exemplo, tem reforçado o apoio a modelos de IA de código aberto e avaliação rigorosa. Este tipo de iniciativa global sublinha a necessidade de que os sistemas de IA sejam desenvolvidos com responsabilidade e transparência, um aspecto cada vez mais valorizado por usuários e reguladores. Para manter a privacidade ao remover informações pessoais do Google, a atenção às fontes e dados é igualmente crítica.

Embora os modelos de IA estejam em constante evolução, pesquisas da Anthropic mostram que IA pode piorar com raciocínio prolongado, o que destaca a complexidade no desenvolvimento desses sistemas. Isso reforça a necessidade de ferramentas que permitam ao usuário verificar os dados. Problemas com o Google Home, por exemplo, também reduzem a confiabilidade dos dispositivos inteligentes, mostrando que a confiança é um fator sensível para qualquer tecnologia.

Esse método simples para o Gemini oferece uma alternativa prática para quem busca mais segurança nas respostas geradas por IA. Ele serve como um lembrete de que, mesmo com a inteligência artificial cada vez mais avançada, a validação humana e a busca por fontes confiáveis continuam sendo práticas indispensáveis no uso dessas tecnologias.

Este conteúdo foi auxiliado por Inteligência Artificiado, mas escrito e revisado por um humano.